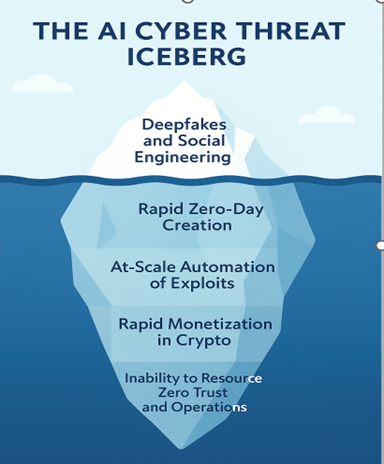

Navigare nell’iceberg della cyber-intelligenza artificiale: deepfake in superficie, zero-day in profondità

L’intelligenza artificiale agentica sta trasformando le minacce informatiche: dal phishing e dai deepfake si passa a exploit zero-day continui e ransomware automatizzati. La maggior parte delle organizzazioni faticherà a tenere il passo, ma la stessa potenza dell’AI può essere impiegata per costruire difese autonome, in grado di riportare l’equilibrio dalla parte dei difensori.

La maggior parte di noi naviga nel mondo digitale senza chiedersi davvero cosa lo faccia funzionare. Ci svegliamo, prendiamo un dispositivo, ci connettiamo a una rete e usiamo applicazioni distribuite tra cloud e data center per lavorare. Poiché tutto “funziona e basta”, è facile pensare che la cybersecurity non abbia bisogno di cambiare. Se un account viene compromesso, lo reimpostiamo. Se un laptop viene infettato, lo ripristiniamo. Se un’applicazione non funziona, la aggiorniamo o la sostituiamo. Queste attività sembrano gestibili, e lo stack di sicurezza continua a lavorare in silenzio sullo sfondo, avvisandoci di tanto in tanto di un problema, mentre firewall, protezione degli endpoint, SIEM e MFA mantengono tutto stabile — almeno finché gli attaccanti non trovano una falla.

La vera sfida è immaginare cosa accade quando quelle falle non vengono più sfruttate da hacker umani impegnati in una campagna alla volta, ma da avversari agentici autonomi: sistemi di intelligenza artificiale capaci non solo di generare contenuti credibili, ma anche di pianificare, agire e adattarsi in autonomia. Diversamente da un semplice chatbot o da uno script, un’AI agentica può mappare un’azienda target, raccogliere informazioni sui dipendenti, lanciare campagne di phishing mirate, modificare tattica se viene bloccata e persino negoziare riscatti gestendo i fondi tramite exchange di criptovalute. In altre parole, non supportano gli attaccanti: sono loro gli attaccanti.

La punta dell’iceberg: deepfake e social engineering

Le minacce più visibili oggi sono i deepfake e il phishing generati dall’AI. Vediamo video manipolati di personaggi pubblici e email che sembrano autentiche. Tuttavia, l’intelligenza artificiale agentica amplifica questi rischi. Immagina un sistema che non si stanca mai di analizzare la tua rete LinkedIn, generare messaggi personalizzati per i tuoi colleghi e modificare l’approccio ogni volta che qualcuno lo ignora. Quello che un tempo era un phishing “a pioggia” sta diventando una manipolazione continua e adattiva, progettata per logorare le difese umane.

Sotto la superficie: exploit zero-day

Le vulnerabilità software fanno parte della realtà. Con un errore ogni poche migliaia di righe di codice, le piattaforme complesse nascondono migliaia di punti deboli. Finora, scoprirli richiedeva abilità, pazienza e fortuna umane. L’AI agentica cambia completamente le regole: può scandagliare repository pubblici, testare applicazioni e concatenare piccole falle per creare exploit funzionanti, in modo continuo.

Il risultato? Mentre i team IT gestiscono cicli di patch che durano settimane, un avversario AI scopre e arma nuove vulnerabilità in poche ore. Il backlog delle falle non corrette diventa una miniera d’oro e i difensori restano sempre indietro.

Attacchi su larga scala, senza mai dormire

Oggi i gruppi criminali riescono già a colpire centinaia di vittime contemporaneamente. Con l’AI agentica, ritmo e scala crescono esponenzialmente. Questi sistemi non hanno bisogno di dormire o di essere supervisionati: scandagliano il web, identificano nuovi obiettivi, generano kit di phishing e gestiscono automaticamente le negoziazioni.

Alcuni gruppi ransomware utilizzano già chatbot per “supportare” le vittime durante l’estorsione. L’AI agentica spingerà questo concetto oltre, conducendo negoziazioni multilingue in tempo reale, adattando le richieste in base ai bilanci aziendali e coordinando più campagne simultaneamente. Ciò che prima era una banda di operatori umani può ora diventare uno sciame di macchine instancabili.

La cripto come volano

Una volta ottenuto l’accesso, l’AI agentica può gestire anche il lato economico del crimine. I pagamenti in criptovaluta vengono automatizzati, riciclati rapidamente e reinvestiti in nuovi strumenti.

Pensa a come è cambiata la finanza con il trading algoritmico — e applica la stessa logica al cybercrime: ogni violazione di successo finanzia la successiva, senza alcun collo di bottiglia umano a rallentare il processo.

La base dell’iceberg: la difficoltà del modello Zero Trust

Il modello Zero Trust è l’obiettivo a cui tutti aspiriamo: mai fidarsi, sempre verificare. Tuttavia, pochissime organizzazioni riescono a implementarlo in modo completo. Gli endpoint non sono aggiornati in modo coerente. L’MFA non copre tutte le applicazioni. Le reti restano troppo piatte. Il traffico cifrato è spesso non ispezionato.

Proprio in questi spazi si muovono meglio gli avversari agentici: analizzano continuamente, cambiano rotta se bloccati e sfruttano tutto ciò che resta non monitorato. Nel frattempo, i team di sicurezza sono sommersi dagli alert, cercando di scalare in numero di persone mentre gli attaccanti scalano grazie all’AI.

La direzione per i difensori

L’iceberg non è un destino inevitabile. Gli stessi principi che rendono pericolosa l’AI agentica possono essere sfruttati per difendersi. Il SOC del futuro combinerà la velocità dell’intelligenza artificiale con il giudizio umano.

Immagina una telemetria unificata su ogni endpoint, firewall e sistema di identità. Politiche applicate in tempo reale su ogni punto della rete. Traffico cifrato decriptato, ispezionato e ri-cifrato in millisecondi. E sistemi di AI che non solo rilevano le minacce, ma le contengono e risolvono autonomamente, consegnando agli analisti un ambiente già stabilizzato.

Non è fantascienza: è la strada da percorrere. Gli analisti resteranno nel ciclo decisionale per definire la strategia, ma l’AI gestirà le prime mille mosse. Quando questa visione si concretizzerà, il modello Zero Trust smetterà di essere un’aspirazione: sarà applicato in modo invisibile e su larga scala.

Per la prima volta dopo decenni, l’equilibrio del potere potrebbe tornare dalla parte dei difensori.

La metafora dell’iceberg resta valida: la parte più pericolosa è quella nascosta sotto la superficie. Con l’AI agentica, quella massa invisibile sta crescendo. L’unico modo per evitare la collisione è adattarsi più velocemente degli avversari che la stanno già costruendo.